ELK生態中分布式文檔存儲 ES數據存取原理與支持服務詳解

ELK(Elasticsearch, Logstash, Kibana)生態以其強大的日志處理和分析能力著稱,而Elasticsearch(ES)作為其核心,提供了高性能的分布式文檔存儲與檢索功能。理解ES如何存儲和提取數據,以及其背后的數據處理與存儲支持服務,是高效使用該技術棧的關鍵。

一、Elasticsearch數據存儲原理

Elasticsearch本質上是一個基于Lucene的分布式搜索引擎,但其數據模型設計為面向文檔的NoSQL存儲。

1. 核心概念與數據模型:

文檔(Document):存儲的基本單元,是一個可被索引的JSON對象,對應數據庫中的一行記錄。

索引(Index):一類相似文檔的集合,是邏輯上的命名空間,對應數據庫中的“表”。

類型(Type):在7.x版本后已被棄用,現在一個索引通常只包含一種文檔類型。

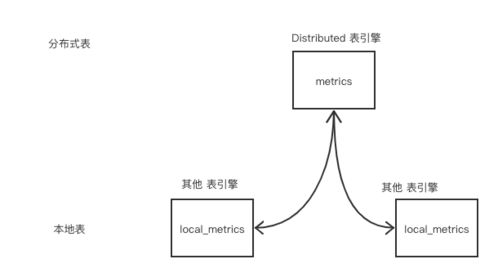

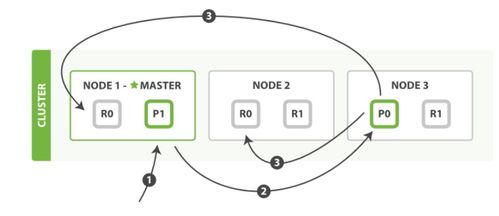

分片(Shard):為實現水平擴展,索引被物理分割成多個分片。每個分片本身是一個功能完整的Lucene索引。分片分為主分片(Primary Shard)和副本分片(Replica Shard)。主分片負責處理寫操作,副本分片提供數據冗余和讀請求的負載均衡。

* 節點(Node):一個運行的ES實例。多個節點組成一個集群(Cluster)。

2. 數據寫入(存數據)流程:

當一個文檔被索引(寫入)時,其旅程如下:

- 客戶端請求:客戶端向集群中任一節點(協調節點)發送寫入請求。

- 路由與目標分片:協調節點根據文檔ID(或自動生成)通過哈希算法確定該文檔應歸屬于哪個主分片。計算公式通常為:

shard<em>num = hash(</em>routing) % num<em>primary</em>shards。其中<em>routing默認為文檔</em>id。這個映射關系在索引創建時確定,之后無法更改主分片數量。 - 轉發請求:協調節點將請求轉發給該主分片所在的數據節點。

- 主分片處理:數據節點在對應的主分片上執行寫入操作。操作首先被寫入事務日志(Translog) 以確保持久性,然后被添加到內存緩沖區。

- 刷新(Refresh)與段(Segment)創建:內存緩沖區默認每1秒(可配置)會“刷新”一次,將緩沖區中的數據清空并創建一個新的、不可變的Lucene段(Segment),此時數據才變得可被搜索。這是一個較耗資源的操作。

- 副本同步:寫入主分片成功后,請求會被并行轉發到所有副本分片。只有所有副本分片也報告成功,協調節點才會向客戶端返回成功響應。這保證了數據的一致性。

- 段合并與持久化:后臺會定期將多個小的段合并為更大的段以提高效率,并刪除已標記刪除的文檔。Translog會定期刷盤(Flush),將段數據持久化到磁盤,并清空舊的Translog。

3. 數據讀取(取數據)流程:

讀取分為文檔獲取(Get by ID)和搜索(Search)。

- 文檔獲取:這是一個點查詢。協調節點同樣通過路由算法找到文檔所在分片(可以是主分片或副本分片),然后直接向該分片發起請求獲取文檔。

- 搜索:這是一個更復雜的過程。

- 查詢階段:協調節點將搜索請求廣播到索引相關的所有分片(主分片或副本分片)。每個分片在本地執行查詢,將匹配文檔的文檔ID和相關性分數構成一個優先級隊列返回給協調節點。

- 取回階段:協調節點合并所有分片的結果,進行全局排序,篩選出最終需要的文檔列表。然后,它再向相關分片發起多文檔獲取請求,組裝完整的文檔內容,最終返回給客戶端。

二、數據處理與存儲支持服務

在ELK生態中,數據的處理與存儲并非僅由ES獨立完成,而是由一系列服務協同支持。

1. 數據攝入與處理管道:

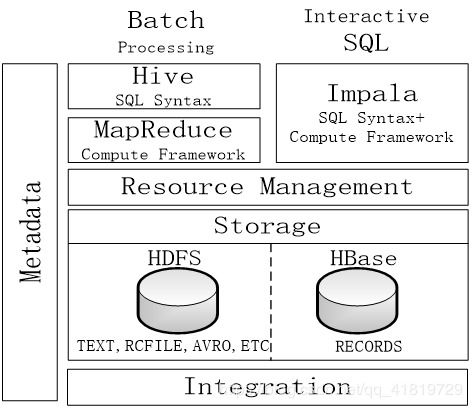

Logstash:作為強大的服務器端數據處理管道,負責從多種來源(文件、Kafka、數據庫等)采集數據,通過豐富的過濾器插件進行解析、轉換、豐富(如解析JSON、Grok解析日志、字段修改、GeoIP查詢等),然后輸出到ES或其他目的地。它為ES提供了結構化和標準化的數據源。

Beats:輕量級的數據采集器家族(如Filebeat用于日志文件,Metricbeat用于指標),通常部署在邊緣服務器上,將數據直接發送到ES或通過Logstash進行進一步處理。

* Ingest Node:ES自身的攝入節點功能。它允許在文檔被索引之前,定義一個預處理管道(Pipeline),對文檔執行類似Logstash的轉換操作(如重命名字段、設置默認值)。這簡化了架構,適用于不需要Logstash復雜功能的場景。

2. 存儲與集群管理支持服務:

分布式協調與發現:ES集群使用Zen Discovery或其下一代替代品(如基于Raft的集群協調層) 來自動發現節點、選舉主節點、管理集群狀態。這是集群高可用和一致性的基礎。

索引生命周期管理(ILM):自動化管理索引從“熱”(活躍寫入和查詢)到“溫”(只讀查詢)再到“冷”(很少訪問)最后“刪除”的整個生命周期。它可以自動滾動創建新索引、遷移分片、調整副本數、刪除過期數據,極大簡化了運維。

快照與恢復(Snapshot & Restore):使用共享存儲庫(如S3, HDFS, 文件系統)對整個集群或指定索引創建快照,用于數據備份、遷移或災難恢復。

監控與管理:ES提供了豐富的API和Kibana的可視化界面,用于監控集群健康、節點狀態、索引性能、查詢負載等,是運維管理的核心工具。

###

Elasticsearch通過其分片、副本、近實時刷新的機制,實現了海量文檔的分布式、高可用、高性能存儲與檢索。在ELK生態中,Logstash/Beats負責數據的預處理和規范化,而ES內部的Ingest Node、ILM、快照等功能則構成了強大的數據存儲與管理支持體系。理解這些原理與服務,有助于我們更好地設計數據管道、優化集群性能、保障數據安全,從而充分發揮ELK棧在大數據搜索與分析領域的強大威力。

如若轉載,請注明出處:http://www.kvqb.cn/product/45.html

更新時間:2026-01-06 16:02:25